Il Paradigma Insostenibile: Decifrare l’Inquinamento IA

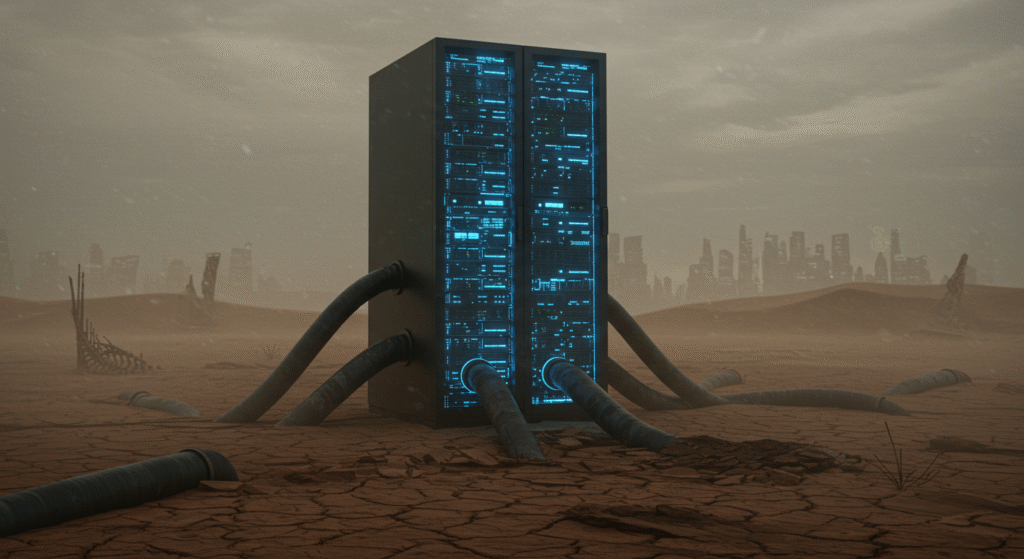

L’incessante dibattito sull’intelligenza artificiale cela una verità scomoda e sempre più manifesta: il crescente inquinamento IA. Mentre organizzazioni come il World Economic Forum la propongono quale panacea per le sfide ambientali, emerge un quadro assai più fosco. L’infrastruttura tecnologica che alimenta questi sofisticati algoritmi si rivela straordinariamente esigente in termini di risorse. Si palesa così un paradosso fondamentale: una tecnologia presentata come salvifica per il pianeta sta, nei fatti, accelerando il depauperamento delle sue risorse energetiche e idriche, configurando una problematica ambientale di non trascurabile entità, la cui discussione non può più essere procrastinata.

L’Impronta Nascosta: Consumi Energetici e Idrici dell’IA

Le metriche relative ai consumi sono emblematiche di una situazione critica. L’addestramento di un singolo modello linguistico avanzato, come GPT-3, ha richiesto un dispendio energetico paragonabile a quello di oltre cento abitazioni statunitensi per un anno intero. Ogni interazione con un chatbot consuma una quantità di elettricità quintuplicata rispetto a una semplice ricerca online. Il fabbisogno idrico per il raffreddamento dei data center è altrettanto allarmante, con stime che prevedono un consumo di quasi sette miliardi di metri cubi d’acqua entro il 2027. Questi dati sostanziano la tesi di un inquinamento IA sistemico, tutt’altro che trascurabile.

Le Mitigazioni Proposte e le Loro Aporie

Di fronte a questa realtà, i giganti del settore digitale avanzano proposte di mitigazione. Amazon dichiara di compensare i propri consumi tramite energie rinnovabili, mentre Microsoft e Google si prefiggono di raggiungere la neutralità carbonica entro il 2030. Tuttavia, tali impegni appaiono spesso discrezionali e insufficienti a controbilanciare un’espansione infrastrutturale senza precedenti. Iniziative come “Exowatt” di Sam Altman o le proposte di autoregolamentazione sulle emissioni, pur lodevoli, rischiano di configurarsi come mere operazioni di facciata, incapaci di affrontare la radice sistemica del problema dell’inquinamento IA.

Una Sostenibilità di Facciata Contro l’Aumento delle Emissioni

Le cosiddette “buone pratiche” suggerite alle aziende – come l’ottimizzazione algoritmica, il rispetto di normative ISO e la formazione del personale – appaiono come palliativi. L’idea che l’IA possa risolvere la crisi climatica analizzando dati e ottimizzando processi è intrinsecamente contraddittoria, poiché la sua stessa operatività divora una porzione crescente del bilancio energetico globale. Secondo l’Agenzia Internazionale dell’Energia, il consumo dei data center è destinato a raggiungere i 1.000 TWh entro il 2026. Nel frattempo, colossi come Google e Microsoft ammettono un incremento delle proprie emissioni, svelando l’ipocrisia di una rivoluzione tecnologica che, per salvare il pianeta, sembra destinarlo a un più rapido esaurimento.

Per approfondimenti:

- Making AI less “thirsty”: Uncovering and addressing the secret water footprint of AI models

Analisi scientifica peer-reviewed (2023) che quantifica il consumo idrico nei data center per l’addestramento di modelli AI come GPT-3/4, evidenziando l’equivalente di centinaia di bottiglie d’acqua per ogni serie di prompt. - Electricity 2024: Analysis and forecast to 2026

Rapporto dell’Agenzia Internazionale per l’Energia con proiezioni sul consumo elettrico globale dei data center (+1000 TWh entro il 2026), inclusi gli impatti specifici dell’IA e le relative implicazioni climatiche. - The Carbon Footprint of Machine Learning Training Will Plateau, Then Shrink

Studio tecnico (2023) che esamina l’evoluzione dell’efficienza energetica nell’addestramento AI, confrontando modelli come GPT-3 con soluzioni ottimizzate e discutendo scenari futuri. - How AI use impacts the environment

Articolo originale del World Economic Forum (giugno 2025) che analizza il paradosso sostenibilità/inquinamento nell’IA, includendo strategie di mitigazione e impegni dei big tech per energie rinnovabili.